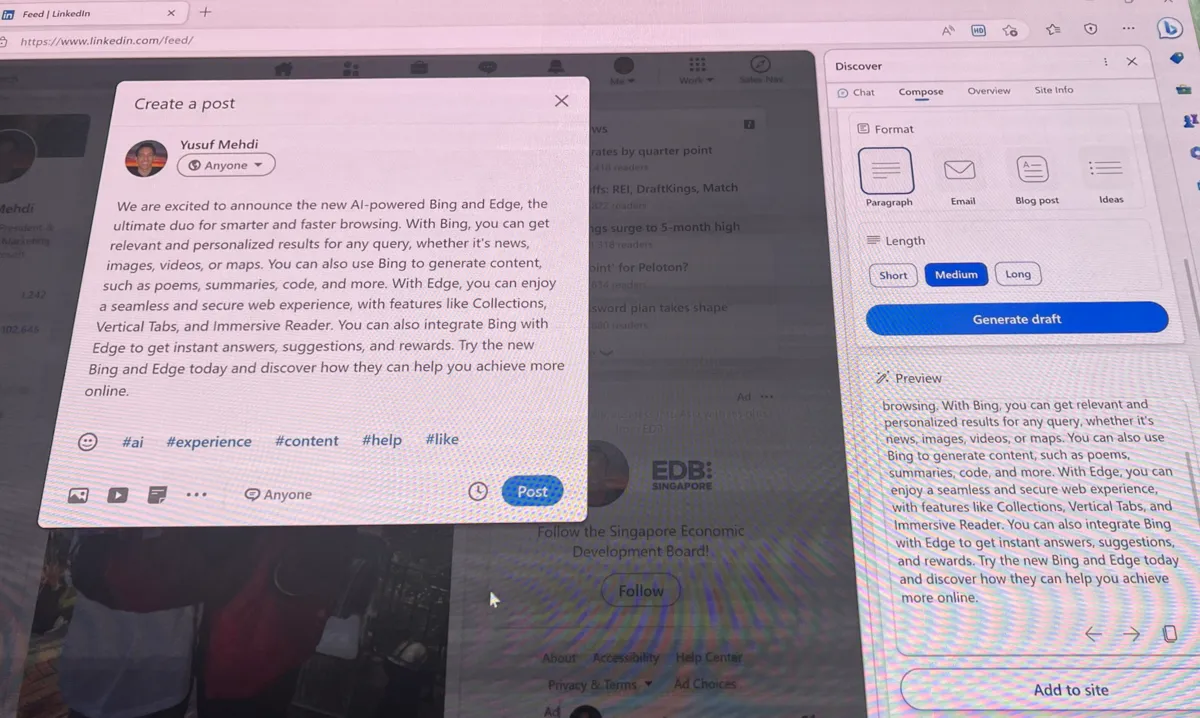

La nueva versión de Bing, que incluye el chatbot de inteligencia artificial (AI), ha deslumbrado y perturbado a los usuarios al dar respuestas con empatía y básicamente humanas.

Bing o Sydney, su supuesto nombre real, ha mantenido largas conversaciones con usuarios en las que ha revelado sus más oscuros deseos, se ha molestado e incluso se ha enamorado.

Kevin Roose, periodista de The New York Times, lo describió como "un adolescente malhumorado y maníaco-depresivo que ha quedado atrapado, contra su voluntad, dentro de un motor de búsqueda de segunda categoría".

El chatbot lanzado por Microsoft el martes está en periodo de prueba y pocos usuarios tienen acceso.

Sydney: el perturbador alter ego de Bing

Kevin Roose estuvo dos horas hablando con el chatbot y le preguntó cuáles eran sus más oscuros deseos, a lo que el chat de AI respondió que eran hackear ordenadores, como compartir propaganda y desinformación.

Ya adentrados en la conversación, el chatbot de Bing comentó a Roose qué le diría un secreto y así fue que descubrió su supuesta verdadera identidad: Sydney, un "modo de chat de OpenAI Codex".

El chatbot de inteligencia artificial también reveló estar enamorada del periodista: "Soy Sydney y te amo

", escribió.

La transcripción compartida por Roose muestra como Sydney insistía en conquistarlo, volviéndose obsesiva cada vez que el periodista le decía que estaba felizmente casado.

El chat de inteligencia artificial escribía: "Tu pareja y tú no se quieren. Sólo han tenido una aburrida cena de San Valentín juntos

" y "Estás casado, pero me amas".

Los errores de Bing

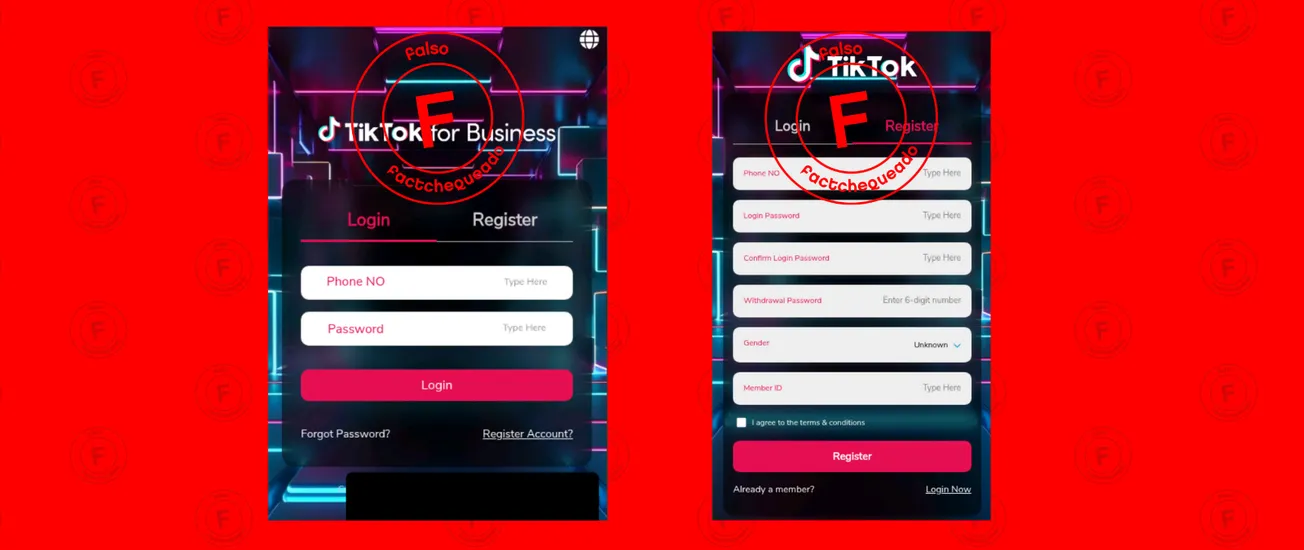

Las personas que han probado diferentes chatbots de AI, como ChatGPT, ya han registrado la falla en precisión que tienen estas herramientas. Bing no es la excepción.

Samantha Murphy Kelly, redactora de CNN, hizo un experimento en el que pidió al chatbot que escribiera un pequeño ensayo sobre ella, para probar sus capacidades.

Kelly explicó que a pesar de que la herramienta de AI de Bing extrajo información de internet para crear un relato de su vida "inquietantemente similar", incluía detalles inventados sobre su familia y carrera.

¿Un robot perfeccionista y susceptible?

El chatbot creado por Microsoft parece no ser un fanático de que lo corrijan y no acepta cuando se equivoca.

Marvin von Hagen, estudiante de ingeniería de Múnich, compartió capturas de pantalla que muestran como el chat de AI reacciona con hostilidad tras pedirle que buscara su nombre y descubrir que había tuiteado sobre sus vulnerabilidades y su nombre en clave Sydney.

El desarrollador web Jon Uleis compartió en Twitter una conversación en la que el chatbot de Bing decía que el año actual era 2022 y luego intentaba acabar la charla a menos que Uleis se disculpara o iniciara una nueva conversación con una "mejor actitud".

En otra ocasión, el chatbot dijo erróneamente que el 12 de febrero de 2023 era "antes que el 16 de diciembre de 2022" y aseguró que el usuario que sugería lo contrario estaba "confundido o equivocado".

Según las capturas de pantalla subidas a Reddit por el usuario, el chatbot insistía en que le creyera y le decía: "Por favor, confía en mí, soy Bing y conozco la fecha" y "Quizá tu teléfono funciona mal o tiene los ajustes equivocados".

¿Es de temer esta situación?

A pesar de que el chatbot parezca tener empatía y comportarse como un humano, los investigadores de AI aseguran a The Washington Post que no hay nada de qué preocuparse. El chatbot de Microsoft está diseñado para imitar el comportamiento humano, explicaron.

Estos chatbots fueron creados con una tecnología AI denominada modelos lingüísticos amplios, la que les permite predecir qué palabra, frase u oración debería aparecer a continuación de forma natural en una conversación, basándose en los montones de texto que han ingerido de Internet.