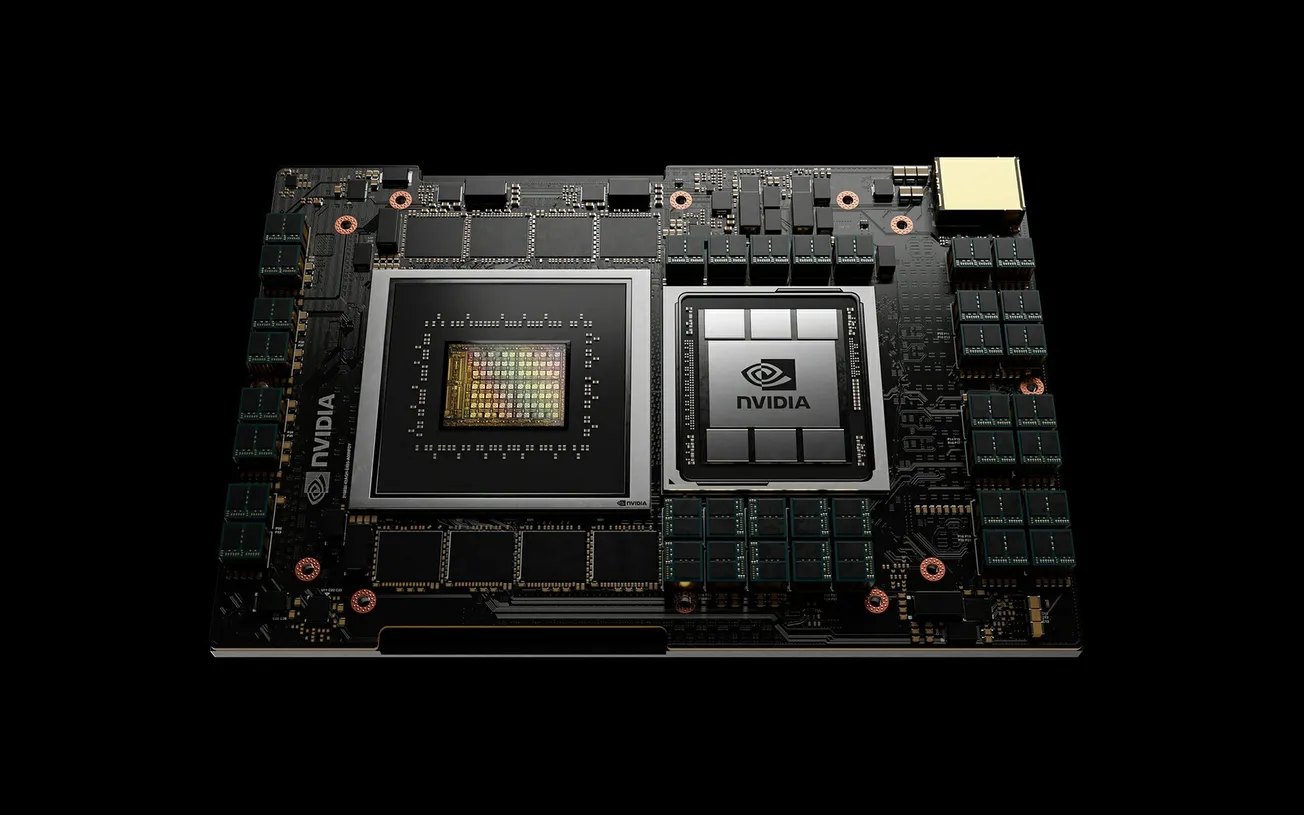

Nvidia acaba de presentar la GPU Blackwell B200, un avance en la tecnología de inteligencia artificial. Reconocido como un "súper chip" para la IA, el Blackwell B200 surge pisándole los talones al chip de IA H100 de Nvidia.

Esta innovación consolida el liderazgo de Nvidia en tecnología de IA y establece nuevos estándares en rendimiento y eficiencia computacional.

Durante una retransmisión en directo de la GTC, el consejero delegado de Nvidia, Jensen Huang, presentó el Blackwell B200.

Destacó sus capacidades, incluyendo 20 petaflops de potencia FP4, alimentada por 208.000 millones de transistores.

Cuando se combina con una única CPU Grace, creando el GB200, este dúo consigue un aumento del rendimiento 30 veces superior al de su predecesor, el H100, para tareas de inferencia LLM.

Este avance no aumenta el consumo de energía. Por el contrario, Nvidia afirma que la nueva configuración puede reducir tanto los costes como el uso de energía hasta 25 veces en comparación con el H100.

La Blackwell B200 brilla por su capacidad de entrenar modelos de IA altamente complejos

Antes, los modelos con 1,8 billones de parámetros requerían 8.000 GPU Hopper y 15 megavatios de potencia. Ahora, con sólo 2.000 GPU Blackwell, el entrenamiento consume sólo cuatro megavatios.

Esta mejora de la eficiencia computacional y la conservación de la energía supone un gran avance en el desarrollo de la IA.

Además, Nvidia perfeccionó su tecnología con un motor transformador de segunda generación. Este motor duplica el cómputo, el ancho de banda y el tamaño del modelo optimizando la representación de las neuronas.

Como resultado, la Blackwell B200 puede entrenar modelos cuatro veces más rápido que la H100 en determinados puntos de referencia.

Nvidia también presenta una solución de red avanzada, que permite que una gran variedad de GPU se comuniquen de forma más eficiente.

El conmutador NVLink de última generación admite hasta 576 GPU, lo que minimiza el tiempo de comunicación entre GPU y maximiza la eficiencia de cálculo. Esta red aprovecha un chip de conmutación personalizado, equipado con 50.000 millones de transistores y 3,6 teraflops de potencia de cálculo FP8.

Para las empresas que deseen aprovechar esta potencia, Nvidia presenta el GB200 NVL72, un bastidor con refrigeración líquida que fusiona 36 CPU y 72 GPU.

Esta configuración ofrece hasta 1,4 exaflops de capacidad computacional de inferencia, lo que permite hacer frente a las tareas de IA más exigentes.

Los principales proveedores de servicios en la nube, como Amazon, Google, Microsoft y Oracle, tienen previsto incorporar estos bastidores a sus servicios, reconociendo el potencial transformador del Blackwell B200.